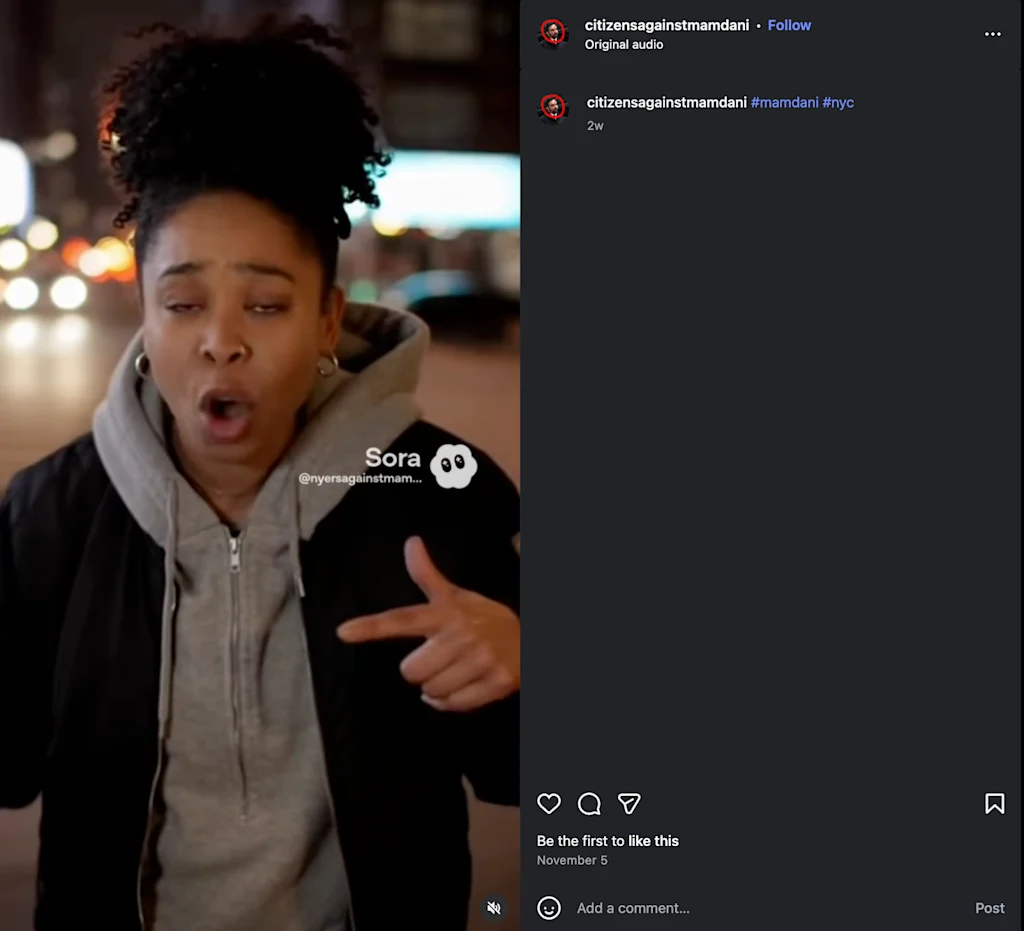

Een griezelig account dat vrijwel zeker wordt gebruikt AI Het genereren van video’s van denkbeeldige New Yorkers die kritiek uiten op de nieuwgekozen burgemeester Zohran Mamdani roept een beangstigend vooruitzicht op: dat deepfakes niet alleen kunnen worden gebruikt om zich voor te doen als politici, maar ook om kiezers na te bootsen.

Accounts op verschillende sociale mediaplatforms – die soortgelijke profielfoto’s gebruiken en met elkaar verbonden lijken te zijn – noemen zichzelf de Citizens Against Mamdani. De afgelopen dagen zijn op deze accounts bekentenissen en tirades geplaatst van ‘New Yorkers’ die Mamdani bekritiseerden vanwege zijn – vermeende – anti-Amerikanisme, plannen om de belastingen te verhogen en valse beloften over huur en transport. Ze lijken de diversiteit van New York te proberen te imiteren, en veel van de video’s bevatten enkele klassieke accenten van de stad.

Hoewel geen van de video’s viraal is gegaan, zijn ze wel verschenen TikTokTwitter en Instagram, waarvan sommige tienduizenden views hebben. Het TikTok-account zelf heeft ongeveer 30.000 likes. Snel bedrijf nam contact op met de Instagram- en TikTok-pagina’s, maar had op het moment van publicatie nog niets gehoord.

“Tijdens de laatste verkiezingscyclus inhuren menselijke beïnvloeders om een bepaalde boodschap te verspreiden waren een rage. Nu hebben teams deze persoonlijkheden niet eens nodig”, legt Emmanuelle Saliba uit, hoofdonderzoeker bij GetReal Security, een cybersecuritybedrijf dat deepfakes analyseert. “GenAI heeft zo’n aanzienlijke vooruitgang geboekt dat campagnes en activisten tekst-naar-video kunnen gebruiken om hyperrealistische video’s van voor- of tegenstanders te maken, en online consumenten zullen er niets wijzer van worden”, voegt ze eraan toe.

De online campagne laat zien hoe generatieve AI astroturfing in essentie heeft gedemocratiseerd. “Astroturfing is geautomatiseerd, en zonder technologie is het vrijwel niet op te sporen,” zegt Saliba – een opmerkelijke evolutie ten opzichte van de laatste verkiezingscyclus, toen het gebruikelijker was dat politieke agenten influencers inhuurden, voegt ze eraan toe.

Het gebruik van online tools om een valse indruk te wekken van steun of verzet tegen een beweging of kandidaat is niet nieuw. In 2017 werden er bijvoorbeeld bots ingezet opmerkingen indienen aan de Federal Communications Commission, die destijds nieuwe regels over netneutraliteit overwoog. Maar dit soort campagnes vergen doorgaans op zijn minst een aanzienlijke menselijke inspanning, zoals het exploiteren van een netwerk van sociale media-accounts of het inhuren van beïnvloeders.

De opkomst van generatieve AI maakt het veel gemakkelijker om online de luchtspiegeling van politieke populariteit te creëren: nu kun je met slechts een paar aanwijzingen en toegang tot het juiste platform eenvoudig video’s genereren van een schare realistisch ogende mensen.

Een luchtspiegeling

Een van de uitdagingen van deepfake-detectie is natuurlijk dat er geen absoluut betrouwbare manier is om te bevestigen dat deze door AI zijn gegenereerd. Bij de anti-Mamdani-video’s is het bewijsmateriaal echter overweldigend.

Naast het zichtbare Sora-watermerk (een label gemaakt door OpenAI om inhoud aan te duiden die met de technologie van het bedrijf is gemaakt) hebben de accounts op sommige video’s rond dezelfde tijd talloze, vergelijkbare video’s gepubliceerd.

Een andere belangrijke hint zijn de objecten op de achtergrond van de beelden, merkte Siwei Lyu op, een professor in computerwetenschappen die deepfakes bestudeert aan de Universiteit van Buffalo.

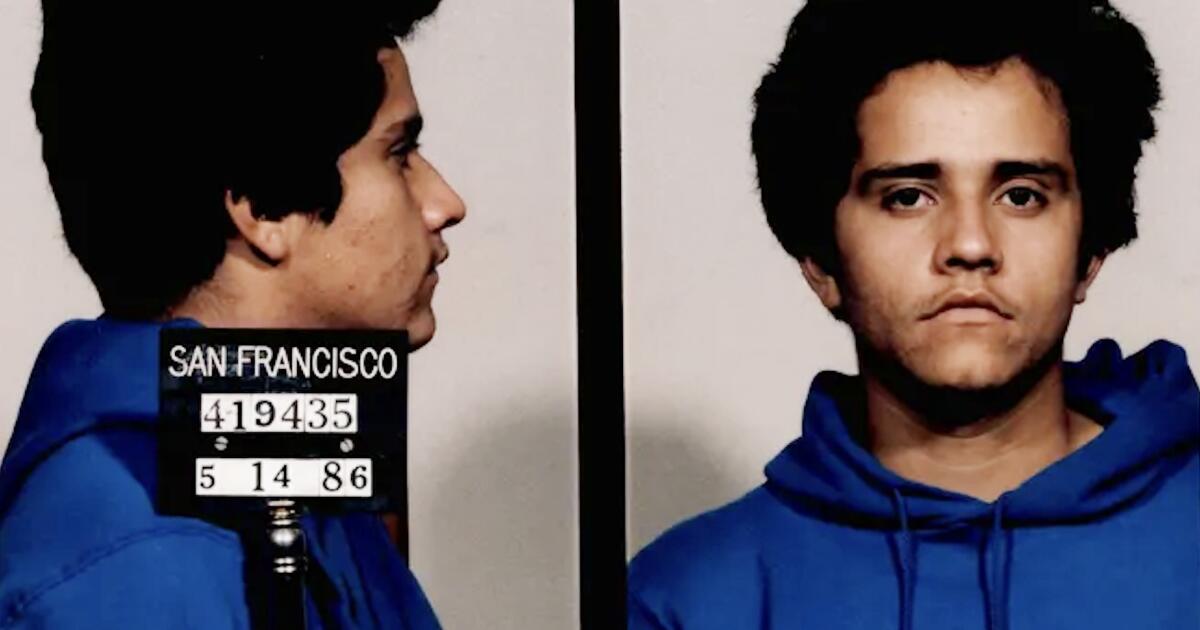

Reality Defender, een ander bedrijf dat door AI gegenereerde inhoud onderzoekt, analyseerde verschillende video’s met behulp van een platform dat het aanbiedt, RealScan genaamd, en ontdekte dat de kans dat ze werden gemanipuleerd extreem hoog was. Het bedrijf oordeelde dat één video waarin een man met een blauwe hoed te zien is en schreeuwt: “Jullie zijn allemaal voor de gek gehouden door Mamdani”, een waarschijnlijkheid van 99% had om een deepfake te zijn. (Het is onmogelijk om 100% te scoren: er is geen manier om de grondwaarheid van de creatie van de inhoud echt te verifiëren).

Hoewel het onduidelijk is in hoeverre mensen daadwerkelijk overtuigd zijn door de video’s, suggereren de reacties daarop dat in ieder geval sommige online gebruikers ze serieus lijken te nemen. “Ze tonen de illusie van brede steun voor of tegen een kwestie, en de mensen die in de video’s worden afgebeeld zijn gewone burgers. Het is dus moeilijker om hun bestaan te verifiëren”, zegt Lyu. “Dit is de zoveelste gevaarlijke vorm van een AI-gestuurde desinformatiecampagne.”

Astroturf op schaal

De rekeningen herinneren ons eraan dat de kosten voor het produceren van desinformatie lager zijn dan ooit. Vroeger was het zo dat social engineering-ondersteuning voor een bepaald doel echte inspanningen vergde, bijvoorbeeld investeren in het creëren van geloofwaardige en realistische inhoud, legt Alex Lisle uit, de chief technology officer van Reality Defender.

“Nu kan ik een LLM definiëren met een sentiment en een boodschap die ik hem probeer over te brengen, en hem vervolgens vragen te bedenken wat hij moet zeggen”, zegt Lisle. “En ik kan dat doen op een schaal die voorheen uren en uren werk vergde”, waarbij ik “honderden verschillende offertes, duizenden verschillende offertes, heel, heel snel produceerde”, voegt hij eraan toe.

Door deepfakes te combineren met grote taalmodellen kunnen politieke agenten niet alleen talloze scripts genereren voor wat een deepfake kan zeggen, maar ook video’s van mensen – met overtuigende stemmen – om daadwerkelijk spreiding die verhalen. ‘Je hebt nu een krachtvermenigvuldiger,’ vervolgde Lisle. “Om dit te doen waren meerdere mensen en uren inspanning nodig. Nu kost het mij alleen maar computerkosten.”

Het probleem reikt verder dan de politiek, benadrukt Saliba van GetReal. Hoewel Mamdani een voorbeeld van een doelwit kan zijn, betekenen de lage kosten van het creëren van dit soort inhoud dat een bedrijf – of een geliefde – het toekomstige onderwerp van dit soort desinformatiecampagnes zou kunnen zijn.