Bedrijven zijn snel tot adoptie overgegaan RAG om LLM’s te aarden in bedrijfseigen gegevens. In de praktijk ontdekken veel organisaties echter dat het ophalen niet langer een kenmerk is dat aan modelinferentie is gekoppeld; het is een fundamentele systeemafhankelijkheid geworden.

Zodra AI-systemen worden ingezet om de besluitvorming te ondersteunen, workflows te automatiseren of te functioneren semi-autonoomfouten bij het ophalen verspreiden zich rechtstreeks in bedrijfsrisico’s. Verouderde context, niet-gecontroleerde toegangspaden en slecht geëvalueerde ophaalpijplijnen verslechteren niet alleen de antwoordkwaliteit; ze ondermijnen het vertrouwen, de compliance en de operationele betrouwbaarheid.

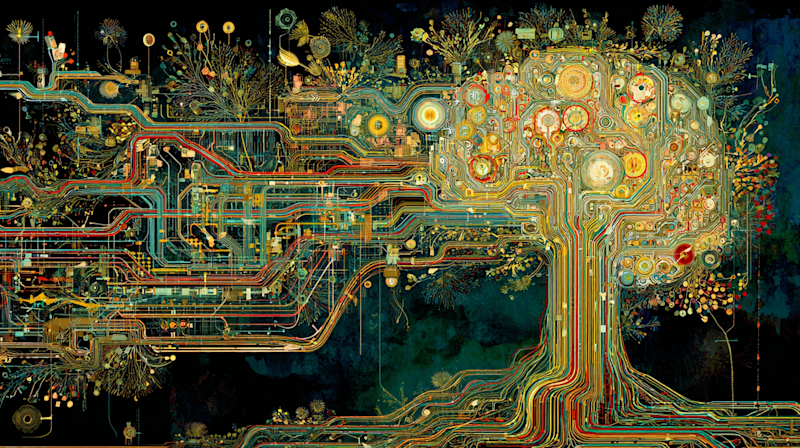

In dit artikel wordt het ophalen opnieuw geformuleerd als infrastructuur in plaats van als applicatielogica. Het introduceert een model op systeemniveau voor het ontwerpen van retrievalplatforms die versheid, beheer en evaluatie ondersteunen als eersteklas architectonische aandachtspunten. Het doel is om ondernemingsarchitecten, AI-platformleiders en data-infrastructuurteams te helpen redeneren over ophaalsystemen met dezelfde nauwkeurigheid die historisch wordt toegepast op computers, netwerken en opslag.

Retrieval as infrastructure – Een referentiearchitectuur die illustreert hoe frisheid, governance en evaluatie functioneren als eersteklas systeemvlakken in plaats van ingebedde applicatielogica. Conceptueel diagram gemaakt door de auteur.

Waarom RAG op ondernemingsschaal kapot gaat

Vroeg RAG-implementaties zijn ontworpen voor beperkte gebruiksscenario’s: zoeken naar documenten, interne vraag-en-antwoordsessies en copilots die opereren binnen strak afgebakende domeinen. Deze ontwerpen gingen uit van relatief statische corpora, voorspelbare toegangspatronen en ‘human-in-the-loop’-toezicht. Die aannames gaan niet langer op.

Moderne AI-systemen voor ondernemingen zijn steeds meer afhankelijk van:

-

Continu veranderende databronnen

-

Meerstaps redeneren over domeinen heen

-

Agentgestuurde workflows die de context autonoom ophalen

-

Regelgevings- en auditvereisten die verband houden met datagebruik

In deze omgevingen lopen de problemen bij het ophalen snel op. Eén enkele verouderde index of een verkeerd opgezet toegangsbeleid kan over meerdere downstream-beslissingen heen lopen. Het behandelen van retrieval als een lichtgewicht verbetering van inferentielogica verdoezelt de groeiende rol ervan als systeemrisicooppervlak.

Het ophalen van de versheid is een systeemprobleem, geen afstemmingsprobleem

Versheidsfouten komen zelden voort uit inbeddingsmodellen. Ze vinden hun oorsprong in het omringende systeem.

De meeste enterprise retrieval-stacks hebben moeite met het beantwoorden van fundamentele operationele vragen:

-

Hoe snel worden bronwijzigingen doorgevoerd in indexen?

-

Welke consumenten stellen nog steeds verouderde representaties ter discussie?

-

Welke garanties bestaan er als gegevens halverwege de sessie veranderen?

Op volwassen platforms wordt frisheid afgedwongen via expliciete architecturale mechanismen in plaats van periodieke verbouwingen. Deze omvatten gebeurtenisgestuurde herindexering, inbedding van versies en bewustzijn bij het ophalen van gegevens.

Bij bedrijfsimplementaties is het terugkerende patroon dat versheidsproblemen zelden voortkomen uit het inbedden van kwaliteit; ze ontstaan wanneer bronsystemen voortdurend veranderen terwijl indexerings- en inbeddingspijplijnen asynchroon worden bijgewerkt, waardoor retrieval-consumenten onbewust in een verouderde context opereren. Omdat het systeem nog steeds vloeiende, plausibele antwoorden produceert, blijven deze hiaten vaak onopgemerkt totdat autonome workflows afhankelijk zijn van voortdurend ophalen en betrouwbaarheidsproblemen op grote schaal aan de oppervlakte komen.

Governance moet zich uitstrekken tot de ophaallaag

De meeste enterprise governance-modellen zijn onafhankelijk ontworpen voor gegevenstoegang en modelgebruik. Ophaalsystemen zitten ongemakkelijk tussen de twee in.

Onbeheerd ophalen brengt verschillende risico’s met zich mee:

-

Modellen die toegang hebben tot gegevens buiten het beoogde bereik

-

Gevoelige velden lekken door inbedding

-

Agenten die informatie ophalen waarvoor ze niet bevoegd zijn om actie te ondernemen

-

Onvermogen om te reconstrueren welke gegevens een beslissing hebben beïnvloed

In ophaalgerichte architecturen moet governance opereren op semantische grenzen in plaats van alleen op opslag- of API-lagen. Dit vereist beleidshandhaving die gekoppeld is aan queries, inbedding en downstream-consumenten – en niet alleen aan datasets.

Effectief ophaalbeheer omvat doorgaans:

-

Domeingerichte indexen met expliciet eigendom

-

Beleidsbewuste ophaal-API’s

-

Audittrails die query’s koppelen aan opgehaalde artefacten

-

Controles op het ophalen tussen domeinen door autonome agenten

Zonder deze controles omzeilen ophaalsystemen stilletjes de beveiligingen waarvan organisaties aannemen dat ze aanwezig zijn.

Evaluatie kan niet stoppen bij de antwoordkwaliteit

Traditionele RAG-evaluatie richt zich op de vraag of de antwoorden juist lijken. Voor bedrijfssystemen is dit onvoldoende.

Mislukkingen bij het ophalen manifesteren zich vaak stroomopwaarts van het uiteindelijke antwoord:

-

Irrelevante maar plausibele documenten opgehaald

-

Ontbrekende kritische context

-

Oververtegenwoordiging van verouderde bronnen

-

Stille uitsluiting van gezaghebbende gegevens

Als AI-systemen autonomer worden, moeten teams het ophalen als een onafhankelijk subsysteem evalueren. Dit omvat het meten van de terugroepactie onder beleidsbeperkingen, het monitoren van de versheidsafwijking en het detecteren van vooroordelen die door terughaalroutes worden geïntroduceerd.

In productieomgevingen heeft de evaluatie de neiging te mislukken zodra het ophalen autonoom wordt in plaats van door mensen teweeggebracht. Teams blijven de kwaliteit van antwoorden beoordelen op steekproefvragen, maar missen inzicht in wat er is opgehaald, wat er is gemist en of verouderde of ongeautoriseerde context beslissingen heeft beïnvloed. Terwijl de ophaalroutes dynamisch evolueren in de productie, stapelt de stille drift zich stroomopwaarts op, en tegen de tijd dat problemen aan de oppervlakte komen, worden mislukkingen vaak ten onrechte toegeschreven aan het gedrag van het model en niet aan het ophaalsysteem zelf.

Evaluatie die het ophaalgedrag negeert, zorgt ervoor dat organisaties blind zijn voor de ware oorzaken van systeemstoringen.

Controlevlakken die het ophaalgedrag bepalen

CEen controlemodel voor retrievalsystemen voor ondernemingen, waarbij uitvoering en beheer worden gescheiden om beleidshandhaving, controleerbaarheid en voortdurende evaluatie mogelijk te maken. Conceptueel diagram gemaakt door de auteur.

Een referentiearchitectuur: Retrieval als infrastructuur

Een opzoeksysteem dat is ontworpen voor zakelijke AI bestaat doorgaans uit vijf onderling afhankelijke lagen:

-

Bronopnamelaag: Verwerkt gestructureerde, ongestructureerde en streaminggegevens met tracering van de herkomst.

-

Inbeddings- en indexeringslaag: Ondersteunt versiebeheer, domeinisolatie en gecontroleerde updatepropagatie.

-

Beleids- en bestuurslaag: Dwingt toegangscontroles, semantische grenzen en controleerbaarheid af tijdens het ophalen.

-

Evaluatie- en monitoringlaag: Meet de versheid, herinnering en naleving van het beleid, onafhankelijk van de modeloutput.

-

Verbruikslaag: Bedient mensen, applicaties en autonome agenten met contextuele beperkingen.

Deze architectuur beschouwt het ophalen als een gedeelde infrastructuur in plaats van applicatiespecifieke logica, waardoor consistent gedrag in alle gebruiksscenario’s mogelijk wordt gemaakt.

Waarom ophalen de betrouwbaarheid van AI bepaalt

Naarmate bedrijven zich meer richten op agentische systemen en langlopende AI-workflows, wordt het ophalen van gegevens het substraat waarop de redenering afhangt. Modellen kunnen slechts zo betrouwbaar zijn als de context waarin ze worden gegeven.

Organisaties die terughalen als een secundaire zorg blijven beschouwen, zullen worstelen met:

-

Onverklaard modelgedrag

-

Nalevingslacunes

-

Inconsistente systeemprestaties

-

Erosie van het vertrouwen van belanghebbenden

Degenen die retrietie verheffen tot een infrastructuurdiscipline – bestuurd, geëvalueerd en ontworpen voor verandering – verwerven een basis die schaalbaar is met zowel autonomie als risico.

Conclusie

Ophalen is niet langer een ondersteunende functie van zakelijke AI-systemen. Het is infrastructuur.

Versheid, bestuur en evaluatie zijn geen optionele optimalisaties; het zijn voorwaarden voor de inzet van AI-systemen die betrouwbaar functioneren in reële omgevingen. Naarmate organisaties verder gaan dan experimentele RAG-implementaties naar autonome en beslissingsondersteunende systemen, zal de architecturale behandeling van retrieval steeds meer het succes of falen bepalen.

Bedrijven die deze verschuiving vroegtijdig onderkennen, zullen beter gepositioneerd zijn om AI op een verantwoorde manier op te schalen, toezicht van de regelgeving te weerstaan en het vertrouwen te behouden naarmate systemen capabeler worden – en meer consequenties hebben.

Varun Raj is een cloud- en AI-ingenieur, gespecialiseerd in cloudmodernisering op ondernemingsschaal, AI-native architecturen en grootschalige gedistribueerde systemen.

Welkom bij de VentureBeat-community!

In ons gastpostprogramma delen technische experts inzichten en bieden ze neutrale, niet-gevestigde diepgaande inzichten over AI, data-infrastructuur, cyberbeveiliging en andere geavanceerde technologieën die de toekomst van het bedrijfsleven vormgeven.

Lees meer uit ons gastpostprogramma — en bekijk ons richtlijnen als u geïnteresseerd bent om een eigen artikel bij te dragen!