- Hyperlink draait volledig op lokale hardware, waardoor elke zoekopdracht privé blijft

- De app indexeert binnen enkele minuten enorme gegevensmappen op RTX-pc’s

- LLM-gevolgtrekking op Hyperlink verdubbelt in snelheid met de nieuwste optimalisatie van Nvidia

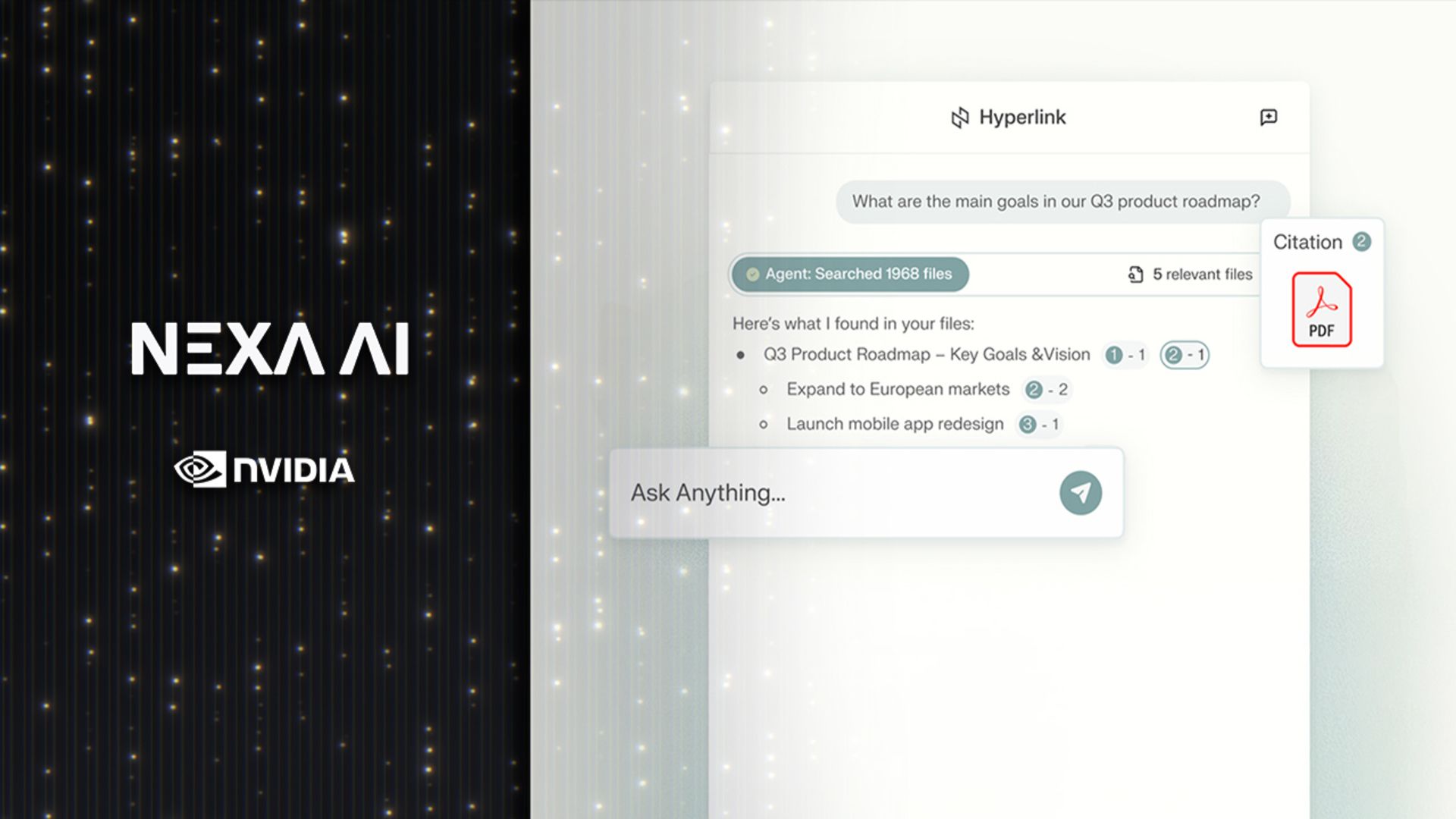

De nieuwe “Hyperlink”-agent van Nexa.ai introduceert een benadering van AI-zoeken die volledig op lokale hardware draait.

De app is ontworpen voor Nvidia RTX AI-pc’s en functioneert als een assistent op het apparaat die persoonlijke gegevens omzet in gestructureerd inzicht.

Nvidia schetste hoe het in plaats van vragen naar externe servers te sturen, alles lokaal verwerkt en zowel snelheid als privacy biedt.

Privé-inlichtingen op lokale snelheid

Hyperlink is gebenchmarkt op een RTX 5090-systeem, waar het naar verluidt tot 3x snellere indexering en 2x de inferentiesnelheid van het grote taalmodel levert vergeleken met eerdere builds.

Deze statistieken suggereren dat het duizenden bestanden op een computer efficiënter kan scannen en ordenen dan de meeste bestaande AI-tools.

Hyperlink matcht niet alleen zoektermen, maar interpreteert de bedoelingen van de gebruiker door de redeneermogelijkheden van LLM’s toe te passen op lokale bestanden, waardoor relevant materiaal kan worden gelokaliseerd, zelfs als bestandsnamen onduidelijk zijn of geen verband houden met de daadwerkelijke inhoud.

Deze verschuiving van statisch zoeken naar trefwoorden naar contextueel begrip sluit aan bij de toenemende integratie van generatieve AI in alledaagse productiviteitstools.

Het systeem kan ook gerelateerde ideeën uit meerdere documenten met elkaar verbinden, waardoor gestructureerde antwoorden met duidelijke referenties worden geboden.

In tegenstelling tot de meeste cloudgebaseerde assistenten bewaart Hyperlink alle gebruikersgegevens op het apparaat, zodat de bestanden die het scant, variërend van pdf’s en dia’s tot afbeeldingen, privé blijven en ervoor zorgen dat geen persoonlijke of vertrouwelijke informatie de computer verlaat.

Dit model spreekt professionals aan die gevoelige gegevens verwerken en toch de prestatievoordelen van generatieve AI willen.

Gebruikers krijgen toegang tot snelle contextuele reacties zonder het risico van gegevensblootstelling die gepaard gaat met externe opslag of verwerking.

Nvidia’s optimalisatie voor RTX-hardware gaat verder dan de zoekprestaties, aangezien het bedrijf beweert dat Retrieval-Augmented Generation (RAG) nu dichte gegevensmappen tot drie keer sneller indexeert.

Een typische verzameling van 1 GB die ooit bijna 15 minuten duurde om te verwerken, kan nu in ongeveer 5 minuten worden geïndexeerd.

De verbetering in de inferentiesnelheid betekent ook dat reacties sneller verschijnen, waardoor dagelijkse taken zoals het voorbereiden van vergaderingen, studiesessies of rapportanalyse soepeler verlopen.

Hyperlink combineert gemak met controle door lokaal redeneren en GPU-versnelling te combineren, waardoor het een nuttig AI-hulpmiddel is voor mensen die hun gegevens privé willen houden.

Volg TechRadar op Google Nieuws En voeg ons toe als voorkeursbron om ons deskundig nieuws, recensies en meningen in uw feeds te krijgen. Klik dan zeker op de knop Volgen!

En dat kan natuurlijk ook Volg TechRadar op TikTok voor nieuws, recensies, unboxings in videovorm en ontvang regelmatig updates van ons WhatsAppen te.